几乎只要程序员在编写计算机程序,黑客就会一直在设法利用这些程序。黑客可能利用程序中最小的漏洞侵入系统,窃取数据,通常他们能造成很严重的破坏。

但是由深度学习算法提供的系统应该能够避免人为的干扰,对吧?黑客怎么可能越过一个在TB级数据上训练的神经网络呢?

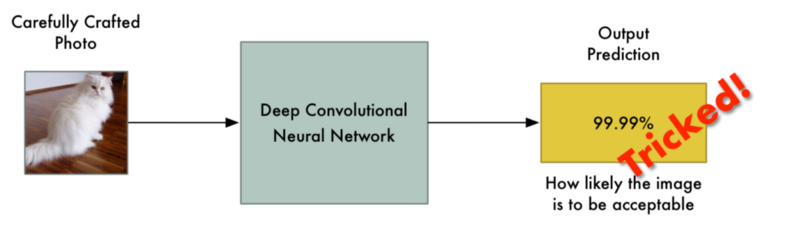

可惜,事实证明即使是最先进的深度神经网络也很容易被欺骗。有一些技巧,可以让你强制它们预测你想要的结果:

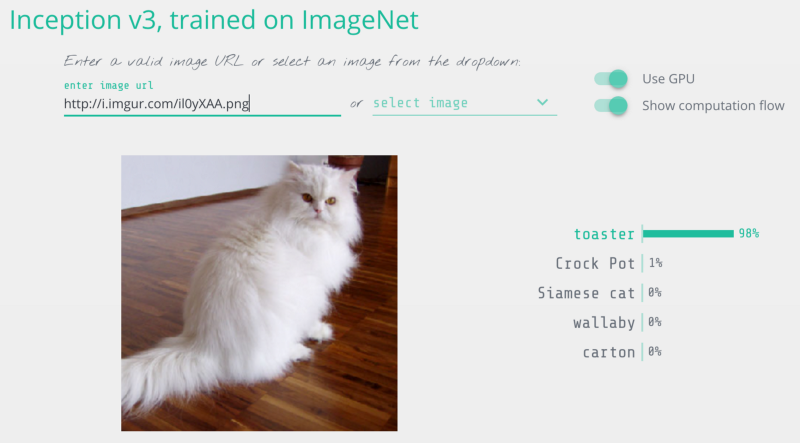

我修改了这张猫图片,所以它被认为是烤面包机

因此,在你发行由深层神经网络驱动的新系统之前,让我们详细了解如何攻击这些系统。

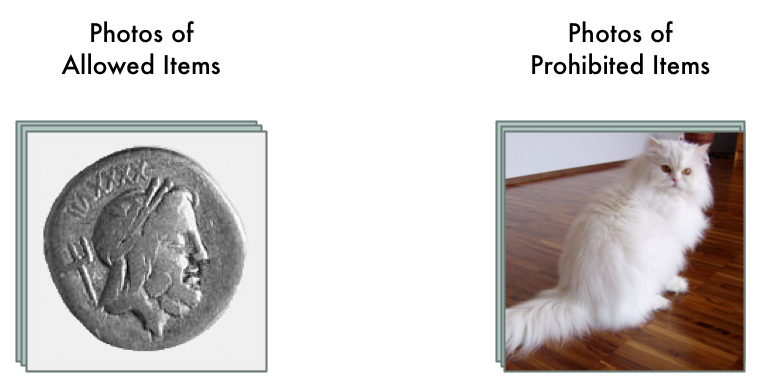

用于审查神经网络我们假设我们经营像Ebay这样的拍卖网站。在我们的网站上,我们想防止人们出售违禁物品,比如动物。

如果你有数百万用户,执行这些规定是很困难的。我们可以聘请数百人手动审查每一个拍卖清单,但这样做成本很高。相反,我们可以使用深度学习自动检查违禁物品的拍卖照片,并标记它们。

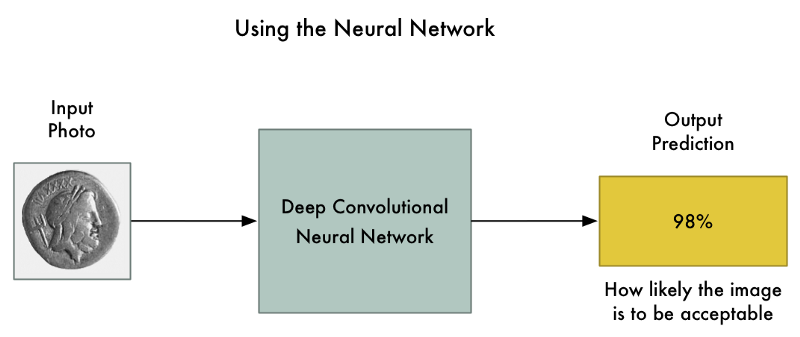

这是一个典型的图像分类问题。为了构建这个,我们将训练一个深度卷积神经网络来区分违禁物品,然后我们将通过它管理我们网站上的所有照片。

首先,我们需要一个来自过去拍卖列表的数千张图像的数据集。我们包含允许物品和禁止物品的图像,以便我们可以训练神经网络来告诉他们:

然后训练神经网络,我们使用标准的反向传播算法。这是一个我们在训练图片中过关的算法,传递该图片的预期结果,然后通过神经网络中的每一层,调整一下它们的权重,使它们在为这张图片产生正确输出的方面做得更好一点:

我们将数千张照片重复上千次,直到模型以可靠的准确性可靠地产生正确的结果。

最终我们得到能够可靠地分类图像的神经网络:

卷积神经网络是对整个图像进行分类时考虑整个图像的强大模型。它们可以识别复杂的形状和图案,无论图形出现在图像什么地方。在许多图像识别任务中,它们拥有等同甚至超过人类的表现。

有了像这么好的模型,将图像中的几个像素变得为更暗或更亮应该不会对最终的预测产生很大的影响的,对吧?当然这也许会稍微改变最终的可能性,但绝不能将图像的识别结果从“被禁止”转换成“被允许”。

我们希望的是:输入照片的细微变化只会对最终的预测造成很小的改变。

但是在2013年的著名论文“神经网络的有趣特性”中,他被发现并总是这样。如果你准确地知道要改变哪个像素,以及要改变多少,你可以有意强迫神经网络预测给定图片的错误输出,并且不会改变图片的外观。

这意味着我们可以有意制作一张明显是禁止物品但完全欺骗了神经网络的图片:

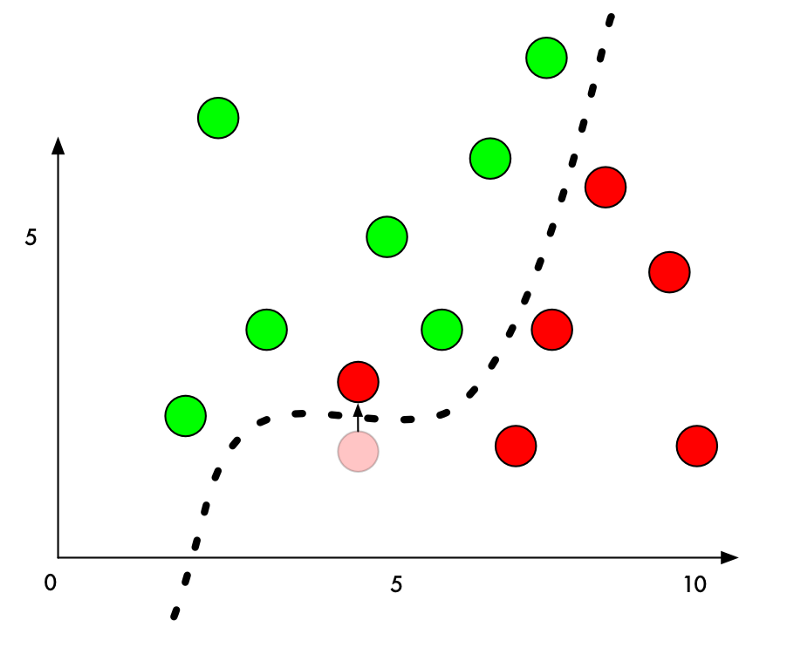

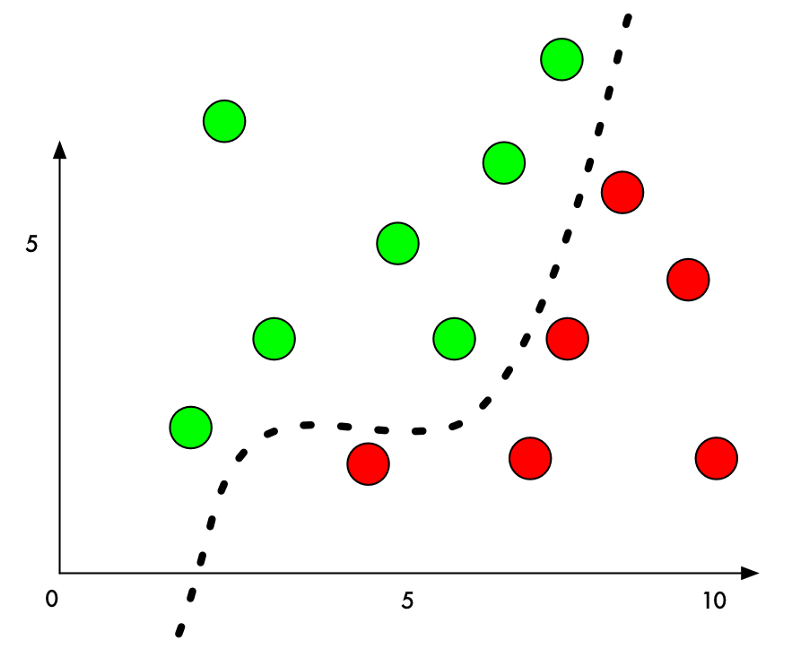

为什么是这样呢?机器学习分类器的工作原理是试图在事物之间找到一条分界线。以下是一个简单的二维分类器的曲线图,它学会了将绿点(接受)与红点(禁止)分开:

现在,分类器的精度达到100%。它看到这条线完美地将所有绿点与红点分开了。

但是,如果我们想欺骗它把一个红点错误的分类成绿点呢?我们可以将红点推向绿点区域的最低限度是多少?

如果我们把边界旁边的红点的Y值增加一丁点,那么我们刚好将它们推到绿色领域: