上篇介绍了使用命令行编译打包运行自己的MapReduce程序,使用 Eclipse 更加方便。要在 Eclipse 上编译和运行 MapReduce 程序,需要安装 Hadoop-eclipse-plugin,可使用 Github 上的 hadoop2x-eclipse-plugin,测试环境:

准备工作安装好 Eclipse,可在 Ubuntu 软件中心直接搜索安装。同时开启 Hadoop。

安装 Hadoop-Eclipse-Plugin下载 hadoop2x-eclipse-plugin ,将 release 中的 hadoop-eclipse-kepler-plugin-2.2.0.jar (虽然标注的是 2.2.0,但在 2.4.1 下是没问题的,应该在 2.x 版本下都可以)复制到 Eclipse 安装目录的 plugin 文件夹中,运行 eclipse -clean 重启 Eclipse 即可。Eclipse 的默认安装目录为:/usr/lib/eclipse :

cd ~/下载/ unzip ./hadoop2x-eclipse-plugin-master.zip cd /usr/lib/eclipse sudo cp ~/下载/hadoop2x-eclipse-plugin-master/release/hadoop-eclipse-kepler-plugin-2.2.0.jar ./plugins/ ./eclipse -clean 配置 Hadoop-Eclipse-Plugin(部分图片直接使用他人的,所以风格不太统一,但不影响)

启动 Eclipse 后就可以在左侧的Project Explorer中看到 DFS Locations(若看到的是 welcome 界面,点击左上角的 x 关闭就可以看到了)。

--------------------------------------分割线 --------------------------------------

CentOS安装和配置Hadoop2.2.0

Ubuntu 12.10 +Hadoop 1.2.1版本集群配置

搭建Hadoop环境(在Winodws环境下用虚拟机虚拟两个Ubuntu系统进行搭建)

--------------------------------------分割线 --------------------------------------

插件需要进一步的配置。

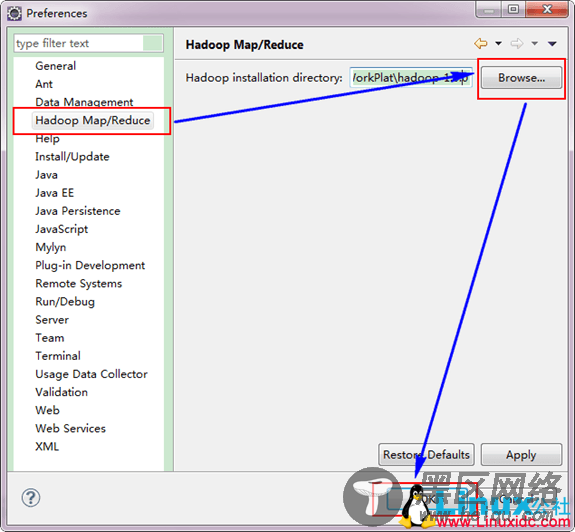

第一步:选择 Window 菜单下的 Preference ,然后弹出一个窗体,窗体的左侧会多出 Hadoop Map/Reduce 选项,点击此选项,选择 Hadoop 的安装目录(如/usr/local/hadoop,Ubuntu不好选择目录,直接输入就行)。

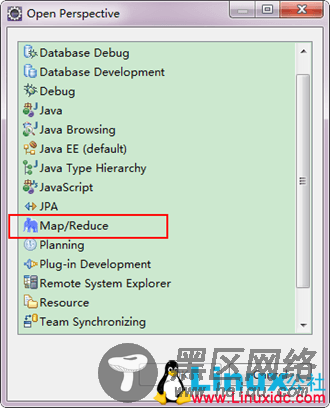

第二步:切换 Map/Reduce 工作目录,选择 Window 菜单下选择 Open Perspective –

Other,弹出一个窗体,从中选择 Map/Reduce 选项即可进行切换。

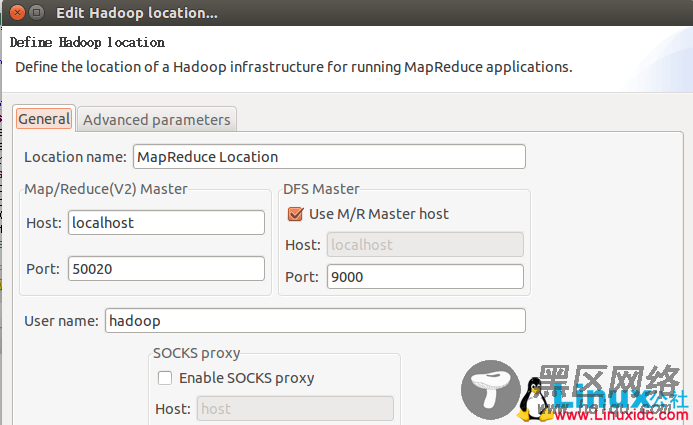

第三步:建立与 Hadoop 集群的连接,点击 Eclipse软件右下角的 Map/Reduce Locations 面板,在面板中单击右键,选择 New Hadoop Location。

在弹出来的 General 选项面板中进行 Master 的设置,设置要要 Hadoop 的配置一致,如我使用的Hadoop伪分布式配置,设置了 fs.defaultFS 为 hdfs://localhost:9000,则 DFS Master 那的 Post 也应改为 9000。

Location Name 随意填写,Map/Reduce Master 的 Host 就填写你本机的IP(localhost 也行),Port 默认就是 50020。最后的设置如下:

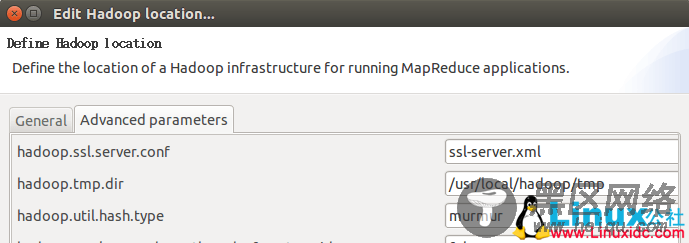

接着再切换到 Advanced parameters 选项面板,这边有详细的配置,切记需要与 Hadoop 的配置(/usr/local/hadoop/etc/hadoop中的配置文件)一致,如我配置了 hadoop.tmp.dir ,就要进行修改。

最后点击 finish,Map/Reduce Location 就创建好了。

这样配置就完成了。