使用椭圆圈起来的是分区,如硬盘sda有三个分区,分别是sda1、sda2、sda3。

可以看到箭头指向的硬盘sdc没有分区,这意味着这块硬盘尚未被使用,这就是我们新添加的硬盘。

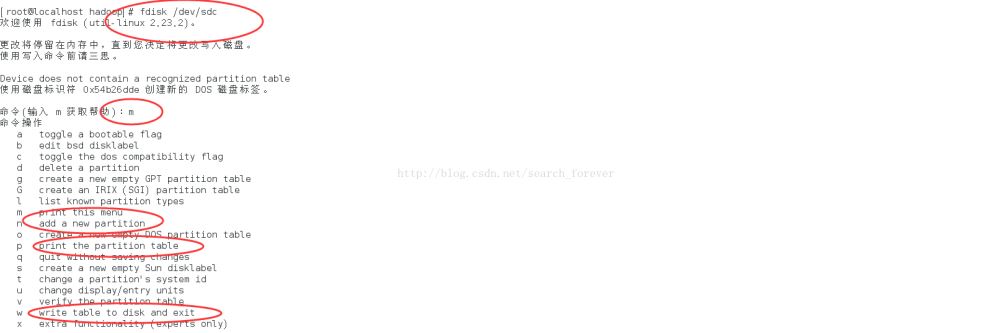

b、通过 fdisk /dev/sdc 对新硬盘进行分区

输入m可以打印我们的操作菜单,注意上边红线圈出 的命令,n代表新建一个分区,p代表打印当前硬盘的分区表,w代表向硬盘写入分区表。接下来我们依次执行。如图:

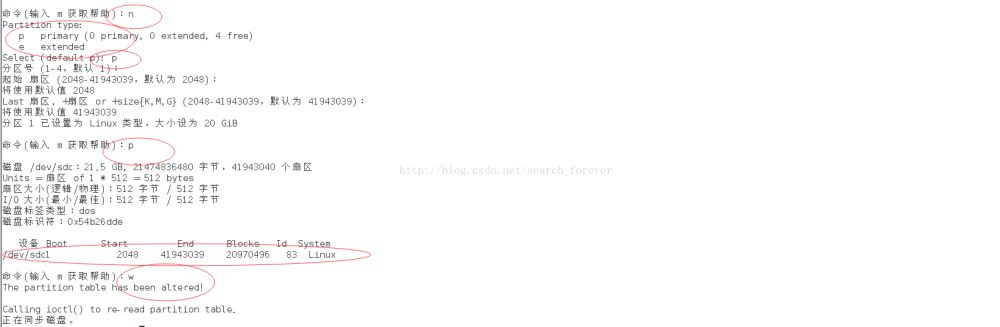

输入n,新建一个分区,两个选项,p代表主分区,e代表扩展分区,选择p主分区;第二次输入p是为了打印分区表,可以看到分区sdc1创建成功。创建过程中的分区好,起始扇区,last扇区使用默认值直接回车即可。最后输入w,写入分区。

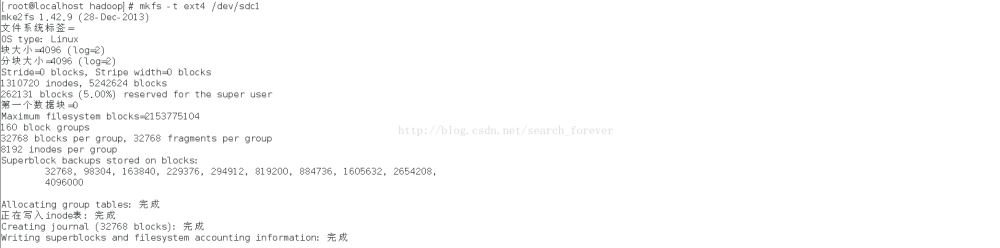

c、使用 mkfs -t ext4 /dev/sdc1 将新分区格式化成ext4的格式

如图:

d、通过 mount /dev/sdc1 /disk5 将新的分区sdc1挂载到目录disk5下边

如图:

最后,我们通过df -lh /disk5 命令查看目录disk5,发现其确实是新的分区sdc1,挂在成功。如此,便可正常使用新加的硬盘了。

小结:用到了 fdisk df mkfs mount 等几个命令,注意复习。

二、hadoop的命令的使用

1、首先需要执行命令使hadoop命令能够被识别。

export PATH=$PATH:/home/hadoop/hadoop-2.5.2/bin

2、hadoop的文件系统的命令与linux的命令十分一致,下边举例说明:

hadoop fs -ls / 表示列出根目录下的所有文件(夹) hadoop fs -put readme.txt /user/hadoop/test/ 表示将readme.txt文件上传到hdfs的/user/hadoop/test/目录下 hadoop fs -get / /hadoop_data 表示将hdfs文件系统根目录/下的所有文件(夹)导出到本地的/hadoop_data目录下 hadoop fs -rm / 表示删除hdfs文件系统中的所有文件(夹)

总结

以上所述是小编给大家介绍的hadoop迁移数据应用实例详解,希望对大家有所帮助,如果大家有任何疑问欢迎给我留言,小编会及时回复大家的!