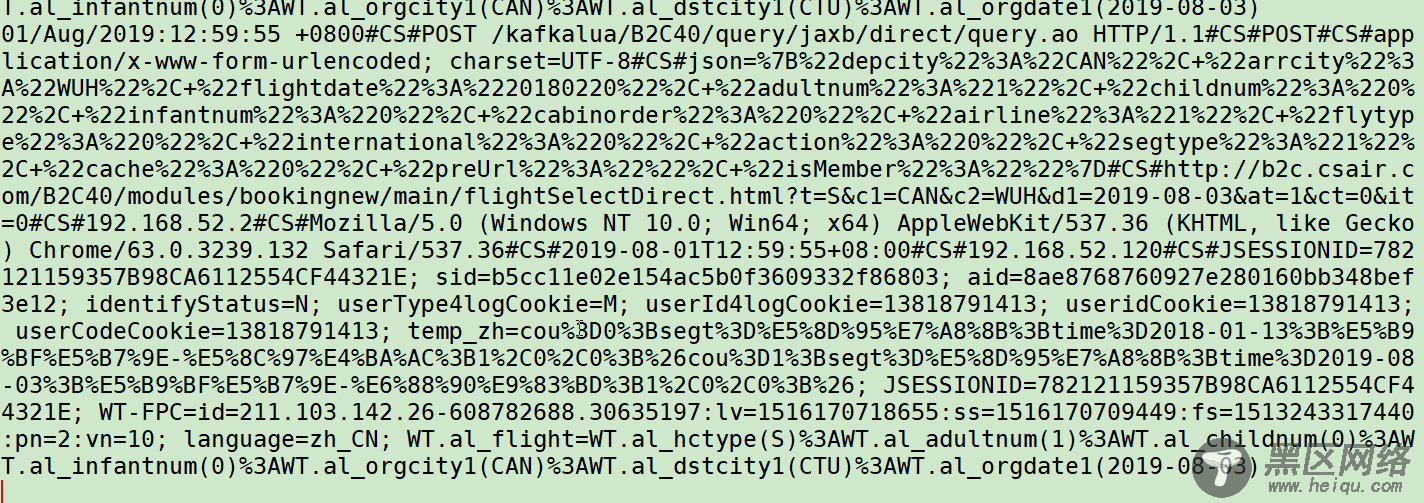

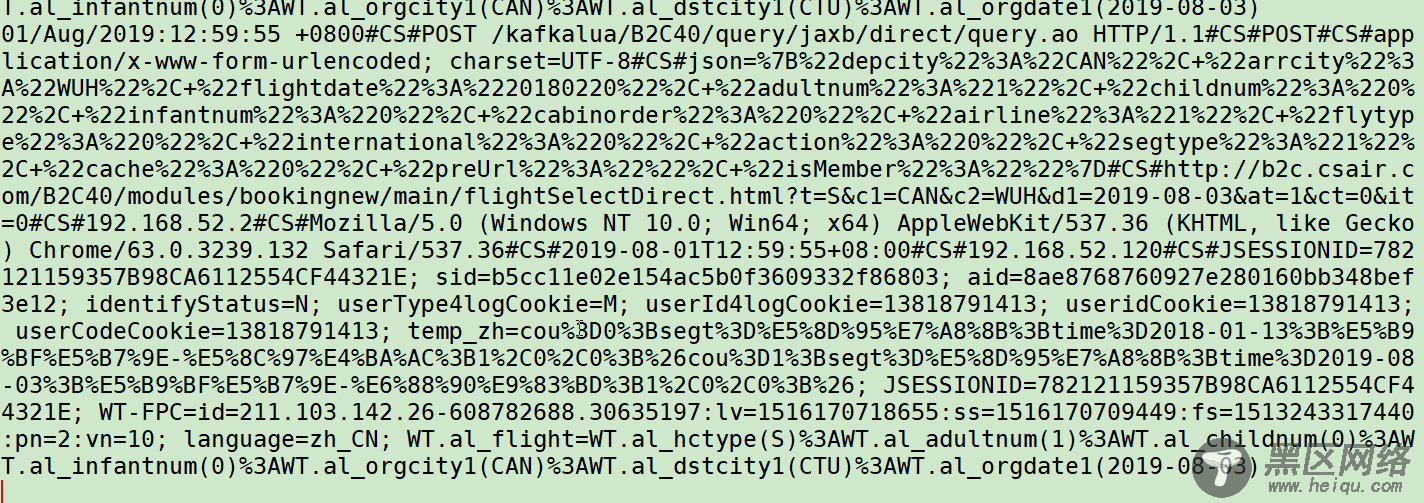

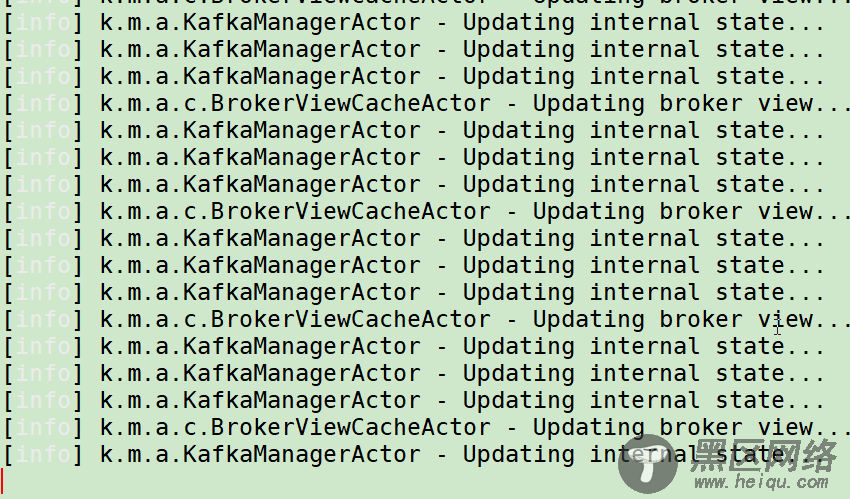

启动后的窗口:

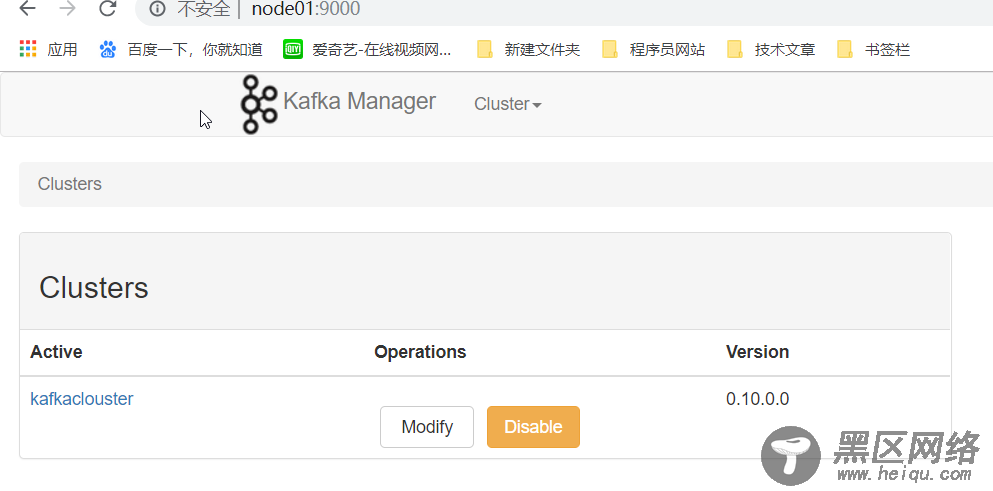

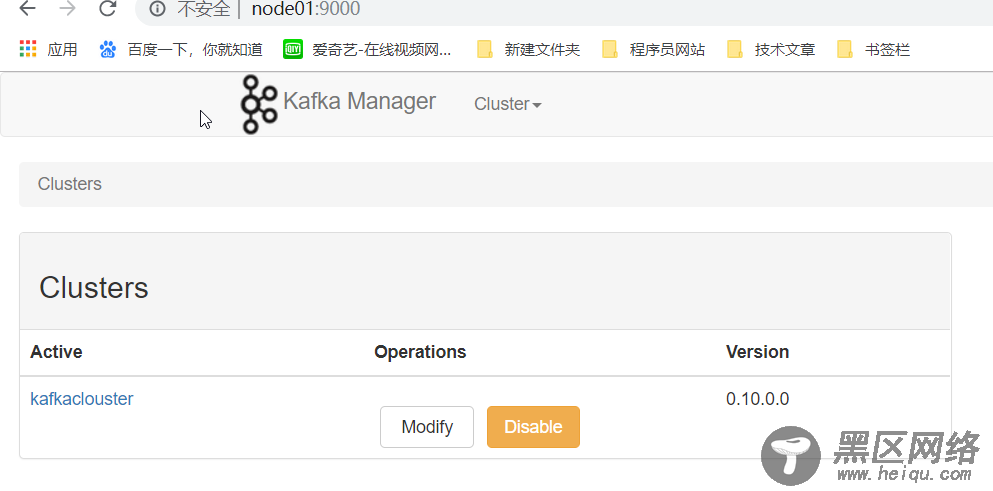

浏览器输入:node01:9000

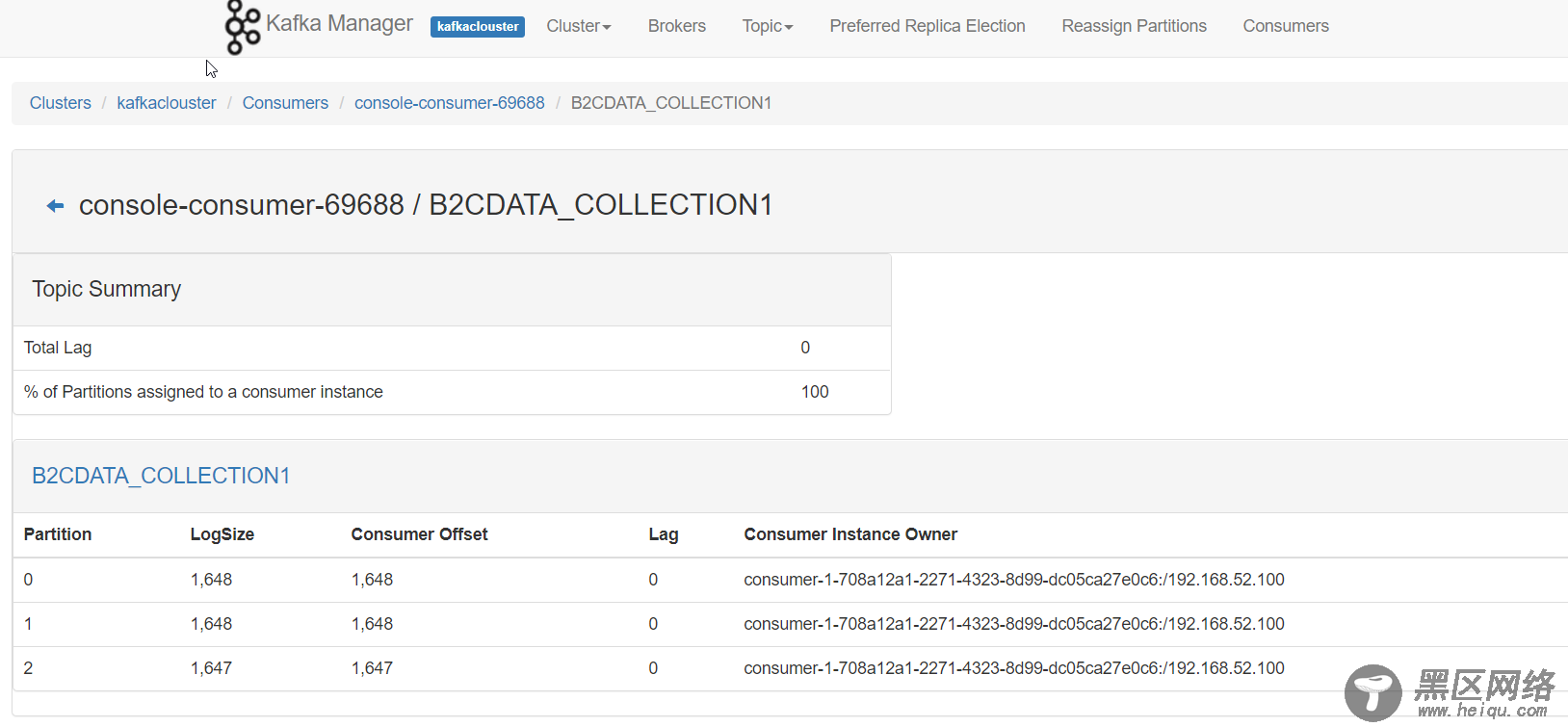

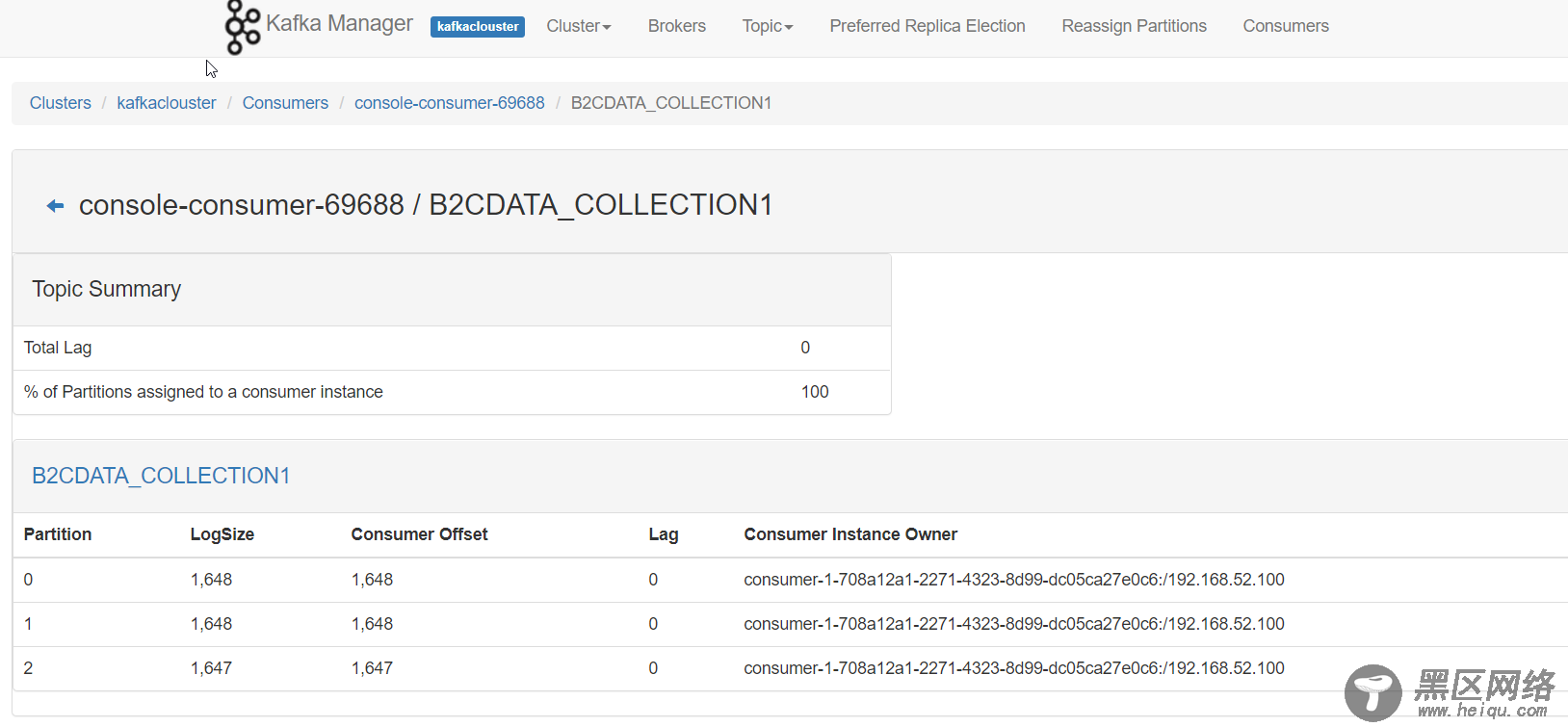

kafka manager使用不做讲解,观察B2CDATA_COLLECTION1主题消费情况:

有三个分区,每个分区消费的消息差多说明成功啦,

如果不一样,则是kafkalua.lua 脚本中没有配置分区策略,默认分区会导致 数据倾斜 我们需配置自己的分区策略!

完毕!

Linux公社的RSS地址:https://www.linuxidc.com/rssFeed.aspx

启动后的窗口:

浏览器输入:node01:9000

kafka manager使用不做讲解,观察B2CDATA_COLLECTION1主题消费情况:

有三个分区,每个分区消费的消息差多说明成功啦,

如果不一样,则是kafkalua.lua 脚本中没有配置分区策略,默认分区会导致 数据倾斜 我们需配置自己的分区策略!

完毕!

Linux公社的RSS地址:https://www.linuxidc.com/rssFeed.aspx

内容版权声明:除非注明,否则皆为本站原创文章。

转载注明出处:https://www.heiqu.com/13cf4a64a5543505e913431ab44abc27.html